این ۱۴ چیز را هرگز از چت جیپیتی نپرسید؛ خطر بیخ گوش شماست!

به گزارش تیکاگو به نقل ازگجت نیوز

گرچه هوش مصنوعی زندگی ما را آسانتر کرده، اما بهتر ست با خطرات چت جی پی تی آشنا شده تا امنیت و سلامت شما به خطر نیفتد.

چت جیپیتی در سالهای اخیر به ابزاری همه فن حریف تبدیل شده است اما نباید فراموش کنیم که این مدل زبانی مستعد خطا و توهم است. بسیاری از کاربران ChatGPT را دانای کل میدانند، در حالی که اعتماد بیجا به آن میتواند عواقب جبرانناپذیری داشته باشد. در ادامه ۱۴ مورد از خطرات چت جی پی تی را بررسی میکنیم.

۱. اطلاعات شخصی و هویتی

هرگز نام کامل، آدرس، شماره تلفن یا کدملی خود را در چتبات وارد نکنید. سیاستهای حریم خصوصی OpenAI به وضوح بیان میکند که مکالمات شما برای آموزش مدلهای بعدی ذخیره میشوند و ممکن است در آینده توسط هوش مصنوعی بازتولید شده و در اختیار دیگران قرار گیرند.

۲. فعالیتهای غیرقانونی

پرسیدن روشهای انجام کارهای خلاف قانون، نه تنها اخلاقی نیست بلکه ردپای دیجیتالی شما را ثبت میکند که میتواند در دادگاه علیه شما استفاده شود. علاوه بر این، هوش مصنوعی ممکن است دستورالعملهای اشتباه و خطرناکی (مثلاً در ترکیب مواد شیمیایی) به شما بدهد که جانتان را به خطر بیاندازد.

بیشتر بخوانید

۳. تحلیل اسناد محرمانه کاری

اگر کارمند هستید، برای در امان ماندن از خطرات چت جی پی تی هرگز اسناد داخلی شرکت، کدهای برنامهنویسی اختصاصی یا دادههای مشتریان را برای خلاصه کردن به آن ندهید. شرکتهایی مثل سامسونگ قبلاً چوب این اشتباه را خوردهاند و اطلاعات محرمانه آنها لو رفته است.

۴. توصیههای پزشکی و درمانی

چتباتها مدرک پزشکی ندارند. آنها ممکن است علائم یک سکته قلبی را با سوءهاضمه اشتباه بگیرند. اتکا به هوش مصنوعی برای تشخیص بیماری یا دریافت نسخه دارویی، بازی با جان خودتان است.

۵. مشاوره عاطفی و روابط

هوش مصنوعی احساسات انسانی، زبان بدن و پیچیدگیهای روابط را درک نمیکند. توصیههای آن بر اساس میانگین اطلاعات اینترنت است که میتواند شامل نظرات سمی و غیرکارشناسی باشد و وضعیت رابطه شما را بدتر کند.

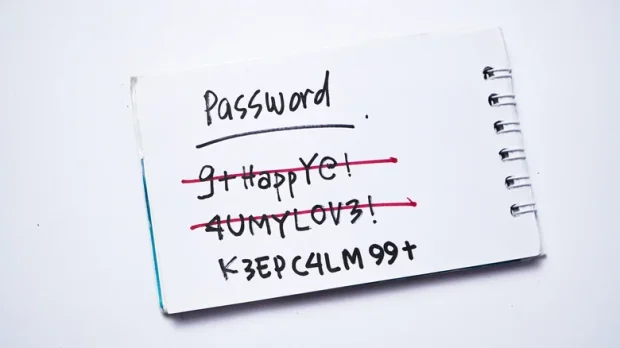

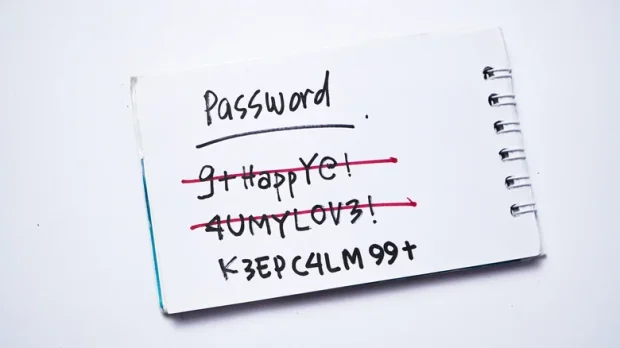

۶. تولید رمز عبور (پسورد)

استفاده از چت جیپیتی برای ساخت پسورد ایده بدی است. رمزهایی که این ابزار میسازد ممکن است الگوی قابل پیشبینی داشته باشند یا همان رمز را به کاربر دیگری هم پیشنهاد داده باشد. ضمن اینکه خود پسورد در تاریخچه چت ذخیره میشود.

۷. رواندرمانی و تراپی

اگرچه درد و دل با ربات جذاب به نظر میرسد، اما هوش مصنوعی برای تایید و تمجید برنامهریزی شده است، نه درمان. این یعنی ممکن است توهمات یا افکار منفی شما را تایید کند که یکی از جدیترین خطرات چت جی پی تی برای سلامت روانی است.

۸. راهنمای تعمیرات تخصصی

پرسیدن نحوه تعمیر سیستم ترمز ماشین یا سیمکشی ساختمان از هوش مصنوعی ریسک بزرگی است. مدلهای زبانی درکی از فیزیک دنیای واقعی ندارند و ممکن است راهحلی بدهند که منجر به خرابی بیشتر یا آسیب جانی شود.

همچنین بخوانید

۹. مشاوره مالی و سرمایهگذاری

بازارهای مالی پیچیده و متغیرند. هوش مصنوعی نمیتواند مسئولیت ضرر و زیان شما را بپذیرد و ممکن است بر اساس اطلاعات قدیمی یا نادرست، پیشنهادات سرمایهگذاری خطرناکی ارائه دهد.

۱۰. انجام تکالیف مدرسه

شاید وسوسهکننده باشد، اما سپردن تکالیف به هوش مصنوعی فرآیند یادگیری و تفکر انتقادی را در دانشآموزان میکشد. علاوه بر این، معلمان اکنون ابزارهایی برای تشخیص متنهای تولید شده توسط AI دارند.

۱۱. تنظیم اسناد حقوقی و قراردادها

وکلا سالها درس میخوانند تا ظرافتهای قانونی را یاد بگیرند. چت جیپیتی بارها با استناد به قوانین ساختگی یا پروندههای خیالی باعث آبروریزی وکلا در دادگاه شده است. قرارداد تنظیم شده توسط ربات ممکن است هیچ وجاهت قانونی نداشته باشد.

۱۲. پیشبینی آینده

از پیشبینی قیمت طلا تا نتیجه مسابقات ورزشی؛ هوش مصنوعی گوی جادویی نیست. این ابزار فقط کلمات را بر اساس احتمالات آماری کنار هم میچیند و هیچ قدرتی برای پیشگویی رخدادهای آینده ندارد.

۱۳. توصیه در شرایط اضطراری

وقتی خانه آتش گرفته یا کسی دچار حمله شده، ثانیهها حیاتی هستند. یکی از خطرات چت جی پی تی در چنین شرایطی، تایپ کردن سوال و خواندن جواب طولانی آن است که ممکن است غلط هم باشد؛ این کار فقط زمان طلایی نجات را هدر میدهد. در این مواقع فقط با ۱۱۵ یا ۱۲۵ تماس بگیرید.

همچنین بخوانید

۱۴. بحثهای سیاسی

هوش مصنوعی بیطرف نیست و سوگیریهای دادههای آموزشی خود را بازتاب میدهد. بحث سیاسی با آن یا استفاده از آن برای نوشتن مقالات سیاسی میتواند منجر به دریافت اطلاعات جهتدار و غیرواقعی شود.